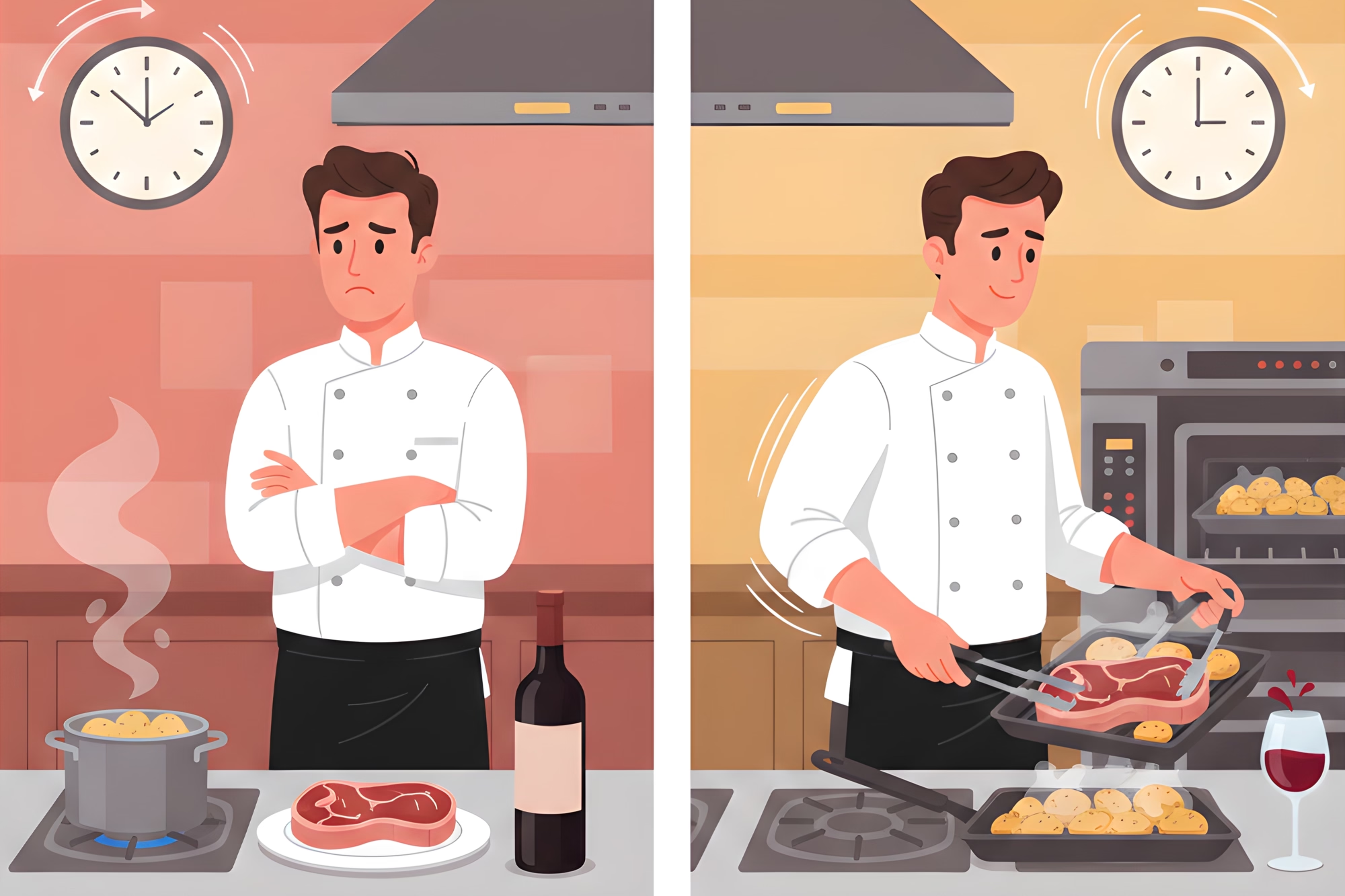

Du bestellst ein Steak, eine Beilage aus Röstkartoffeln und ein Glas Wein. Stell dir nun vor, die Küche würde so arbeiten: Der Koch bringt das Wasser für die Kartoffeln zum Kochen. Erst wenn die Kartoffeln fertig sind, beginnt er, das Steak anzubraten. Erst wenn das Steak auf dem Teller angerichtet ist, geht er in den Keller, um deinen Wein zu suchen.

Bis der Wein eintrifft, ist dein Steak kalt, deine Kartoffeln sind matschig und du hast wahrscheinlich eine Ein-Sterne-Bewertung auf Yelp hinterlassen.

In einer professionellen Küche passieren die Dinge gleichzeitig. Während die Kartoffeln rösten, wird das Steak scharf angebraten; während das Steak ruht, wird der Wein eingeschenkt. Das ist nicht nur ein "Nice-to-have", es ist der einzige Weg, eine heiße Mahlzeit in unter einer Stunde zu servieren.

Dennoch sind viele KI-Agenten immer noch wie diese Ein-Mann-Küche aufgebaut. Sie folgen einer starren, sequenziellen Kette: Schritt A, dann Schritt B, dann Schritt C.

In diesem Kapitel lassen wir die "Eins-nach-dem-Anderen"-Mentalität hinter uns und erkunden das Parallelisierungs-Muster.

Der Latenz-Flaschenhals: Warum sequenzielle Ketten scheitern

In unseren bisherigen Diskussionen haben wir uns mit Prompt Chaining (Dinge nacheinander tun) und Routing (den richtigen Pfad wählen) beschäftigt. Diese sind großartig für die Logik, aber oft langsam.

Wenn dein Agent Informationen aus vier verschiedenen Quellen sammeln muss und jeder API-Aufruf zwei Sekunden dauert, lässt ein sequenzieller Agent den Nutzer acht Sekunden lang warten.

Die Kosten des Wartens

Jeder sequenzielle Schritt fungiert als eine Art "Latenz-Steuer". Wenn Aufgaben unabhängig voneinander sind (Schritt B benötigt nicht die Ausgabe von Schritt A, um zu beginnen), ist es reine Zeitverschwendung, sie in eine Warteschlange zu zwingen.

Der Parallel-Shift: Anstatt darauf zu warten, dass eine Suche abgeschlossen ist, bevor die nächste beginnt, ermöglicht die Parallelisierung dem Agenten, mehrere "Teilaufgaben" gleichzeitig abzufeuern.

💡 Kern-Erkenntnis: Bei der Parallelisierung geht es darum, die Teile eines Workflows zu identifizieren, die nicht voneinander abhängen, und diese gleichzeitig auszuführen.

Wie Parallelisierung funktioniert

Stell dir Parallelisierung als ein "Verzweigen" (Forking) des Workflows vor. Der Agent erreicht einen Punkt, an dem er mehrere Informationen oder verschiedene Entwürfe benötigt, und teilt die Arbeit auf mehrere "Arbeiter" (LLM-Aufrufe oder Tools) auf.

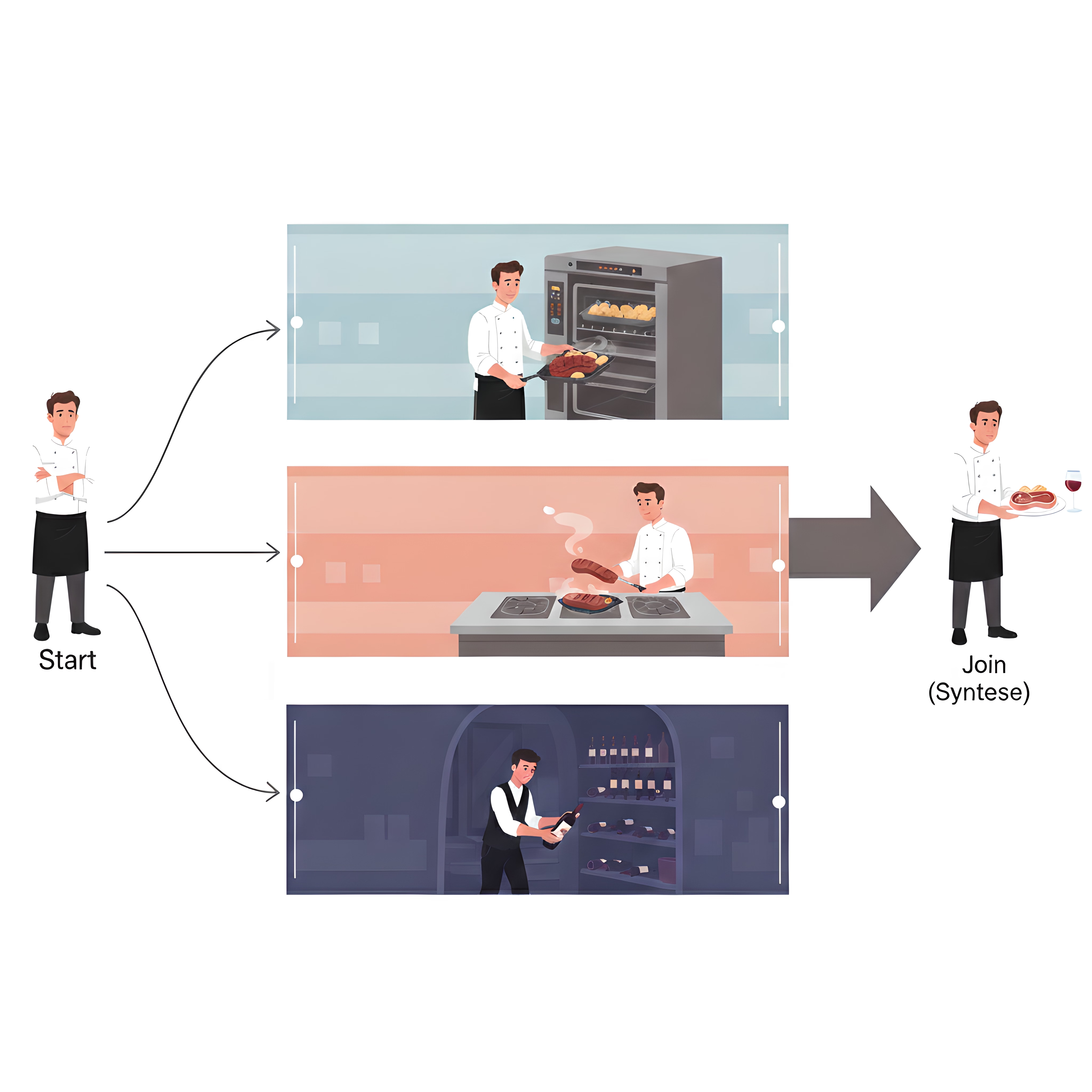

Das "Fork and Join"-Modell

Erinnerst du dich an unsere Restaurantküche? Der Workflow eines Profikochs ist ein perfektes Beispiel für das Fork and Join-Modell:

- The Fork (Die Verzweigung): Der Koch identifiziert unabhängige Aufgaben wie das Rösten der Kartoffeln, das Anbraten des Steaks und das Holen des Weins und startet sie gleichzeitig. Bei einem KI-Agenten ist dies der Punkt, an dem das System Aufgaben wie "News suchen" und "Aktienkurs prüfen" identifiziert, die nicht voneinander abhängen.

- Die Ausführung: Mehrere Dinge passieren gleichzeitig. Während die Kartoffeln rösten, brät das Steak und der Sommelier holt deinen Wein. Für einen Agenten bedeutet dies mehrere LLM-Aufrufe oder Tool-Einsätze zur gleichen Zeit.

- The Join (Die Synthese): Sobald alle parallelen Aufgaben abgeschlossen sind, "vereint" das System die Ergebnisse. Genau wie der Koch das Steak neben den fertigen Kartoffeln anrichtet und beides mit dem Wein präsentiert, synthetisiert der Agent alle gesammelten Informationen zu einer kohärenten Antwort. Dieser letzte Schritt ist meist sequenziell, da er alle vorherigen Ausgaben benötigt, um eine finale Zusammenfassung zu erstellen.

Das Fork-and-Join-Modell: Aufgaben werden parallel ausgeführt und am Ende zur finalen Antwort synthetisiert.

Anwendungsfälle aus der Praxis

Wo macht das wirklich einen Unterschied? Hier sind die häufigsten Wege, wie Parallelisierung genutzt wird, um Hochleistungs-Agenten zu bauen:

1. Umfassende Recherche

Ein Agent, der ein Unternehmen recherchiert, sollte nicht erst Nachrichten, dann Aktien und dann soziale Medien nacheinander prüfen. Er sollte alle drei Datenbanken gleichzeitig abfragen, um in einem Bruchteil der Zeit eine 360-Grad-Ansicht zu liefern.

2. Der Reiseplaner

Wenn du einen Agenten bittest, eine Reise nach Paris zu planen, kann er Flugpreise, Hotelverfügbarkeit und lokale Veranstaltungskalender simultan prüfen. Die wahre Stärke zeigt sich im Join-Schritt: Der Agent listet die Ergebnisse nicht nur auf, sondern gleicht sie ab. Er stellt beispielsweise sicher, dass die Check-in-Zeit im Hotel mit deiner Flugankunft übereinstimmt, oder weist darauf hin, dass das Konzert, das du besuchen wolltest, an deinen Reisetagen ausverkauft ist.

Vorteil: Du erhältst einen vollständigen, kohärenten Reiseplan in drei statt in zwölf Sekunden.

3. Content-Erstellung & A/B-Testing

Brauchst du eine Marketing-E-Mail? Ein Agent kann gleichzeitig drei verschiedene Betreffzeilen, einen Entwurf für den Text und einen Prompt für ein Header-Bild generieren. Er kann sogar mehrere Varianten derselben Antwort erstellen, damit ein "Judge"-LLM (Richter-Modell) die beste auswählt.

4. Assistent für die Sitzungsvorbereitung

Vor einem Kundengespräch kann ein Agent gleichzeitig die letzten E-Mails des Kunden abrufen, die neuesten Firmennachrichten prüfen, relevante Verkaufsdaten aus deinem CRM sammeln und Notizen aus vergangenen Meetings durchsehen. Während ein Arbeiter die Finanzdaten abruft, scannt ein anderer nach neuesten Support-Tickets, und ein dritter prüft LinkedIn auf Personalwechsel beim Kunden.

Vorteil: Statt 30 Minuten lang in verschiedenen Systemen zu suchen, gehst du in Sekundenschnelle voll informiert in das Meeting.

Strategievergleich: So implementierst du Parallelismus

Genau wie ein Küchenchef entscheiden muss, wie er seine Brigade führt, musst du eine Architektur wählen, die bestimmt, wie die parallele Arbeit deines Agenten verwaltet wird.

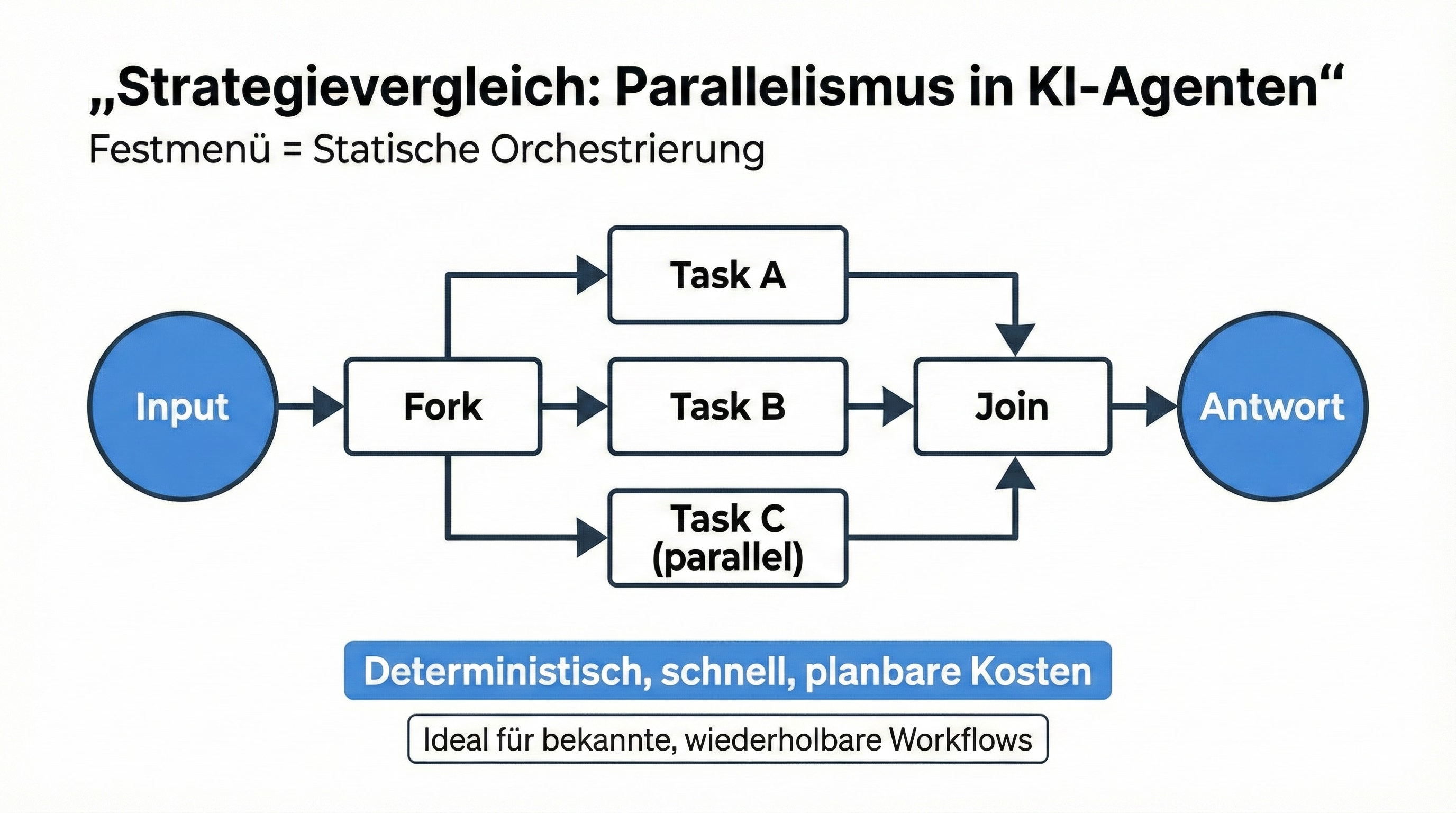

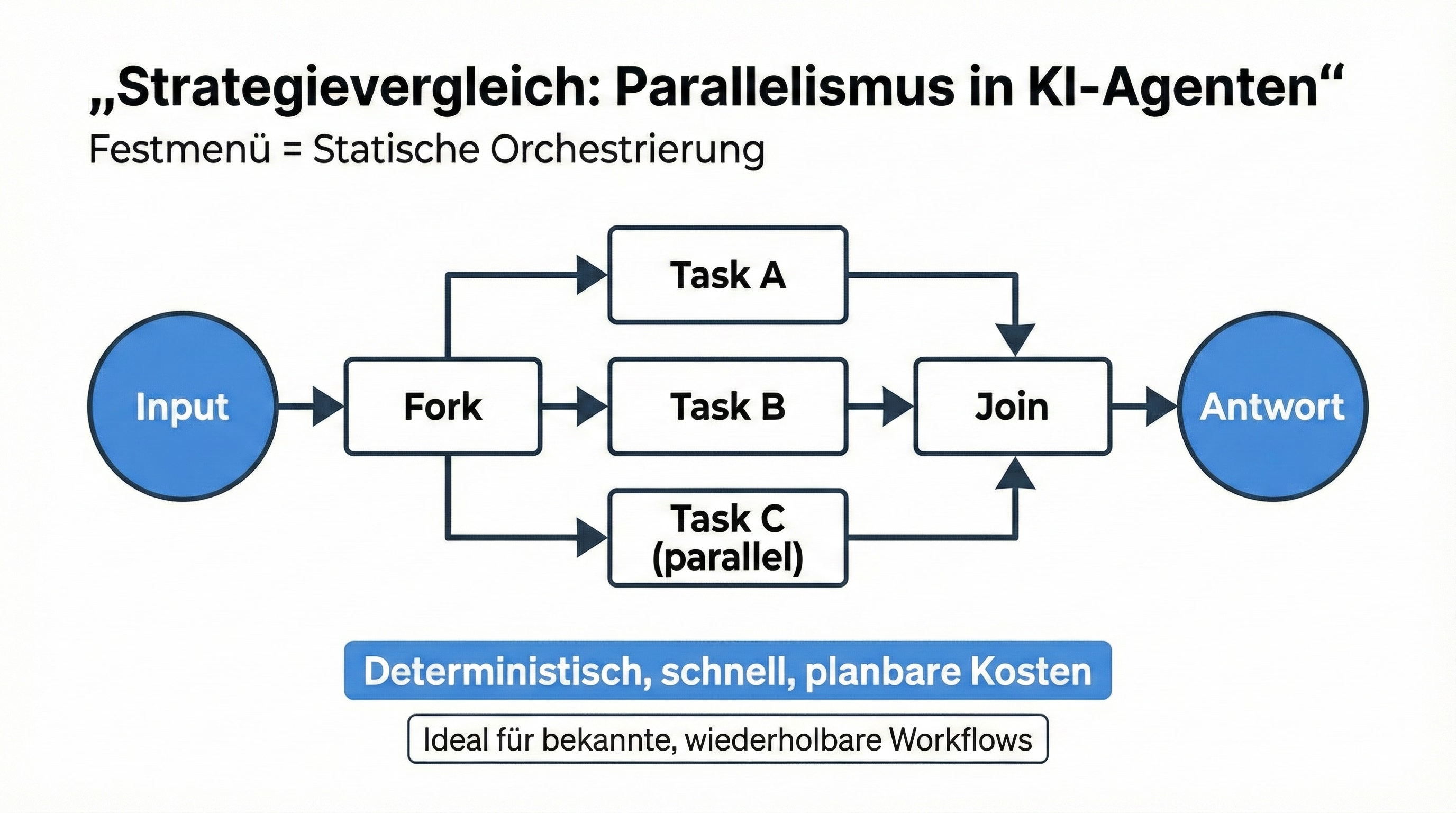

Das "Festmenü" (Statische Orchestrierung)

Dies ist wie eine Küche, die nur ein Fünf-Gänge-Menü serviert, bei dem der Koch genau weiß, welche drei Vorspeisen für jeden Gast gleichzeitig vorbereitet werden müssen.

Technisch gesehen ist dies Statische Orchestrierung. Du nutzt Konstrukte wie LCEL (LangChain Expression Language) oder Pythons asyncio, um die "Fork"- und "Join"-Punkte fest im Code zu verankern. Da die Logik deterministisch ist, muss das System nicht "nachdenken", was als Nächstes zu tun ist; es feuert einfach die parallelen Ketten ab.

Festmenü = Statische Orchestrierung: Deterministisch, schnell, planbare Kosten. Ideal für bekannte, wiederholbare Workflows.

Dies ist der Goldstandard für schnelle, zuverlässige Datenverarbeitung, bei der du die niedrigstmögliche Latenz und vorhersehbare API-Kosten wünschst.

Der "À-la-carte-Koch" (Modell-gesteuerte Parallelität)

Stell dir einen Koch vor, der eine Bestellung sieht und spontan entscheidet: "Ich kann die Fritten in die Fritteuse geben, das Brötchen toasten und das Patty grillen, und das alles gleichzeitig."

Dies ist Native Parallel Tool Calling, eine Fähigkeit, die zum Rückgrat von Frontier-Modellen wie GPT-5 und Claude 4 geworden ist (Hinweis: Dies sind Platzhalter für Next-Generation-Frontier-Modelle). Anstatt dass du die Schritte definierst, analysiert das Modell die Absicht des Nutzers und erkennt selbst, dass es mehrere verschiedene Tools benötigt, um zu antworten. Es löst sie alle in einem einzigen Durchgang aus.

Dies bietet unglaubliche Flexibilität für unvorhersehbare Anfragen, bringt aber eine Reasoning-Gebühr mit sich: Der Agent ist autonomer, aber du hast weniger Kontrolle darüber, wie viele Tools er genau abfeuern könnte.

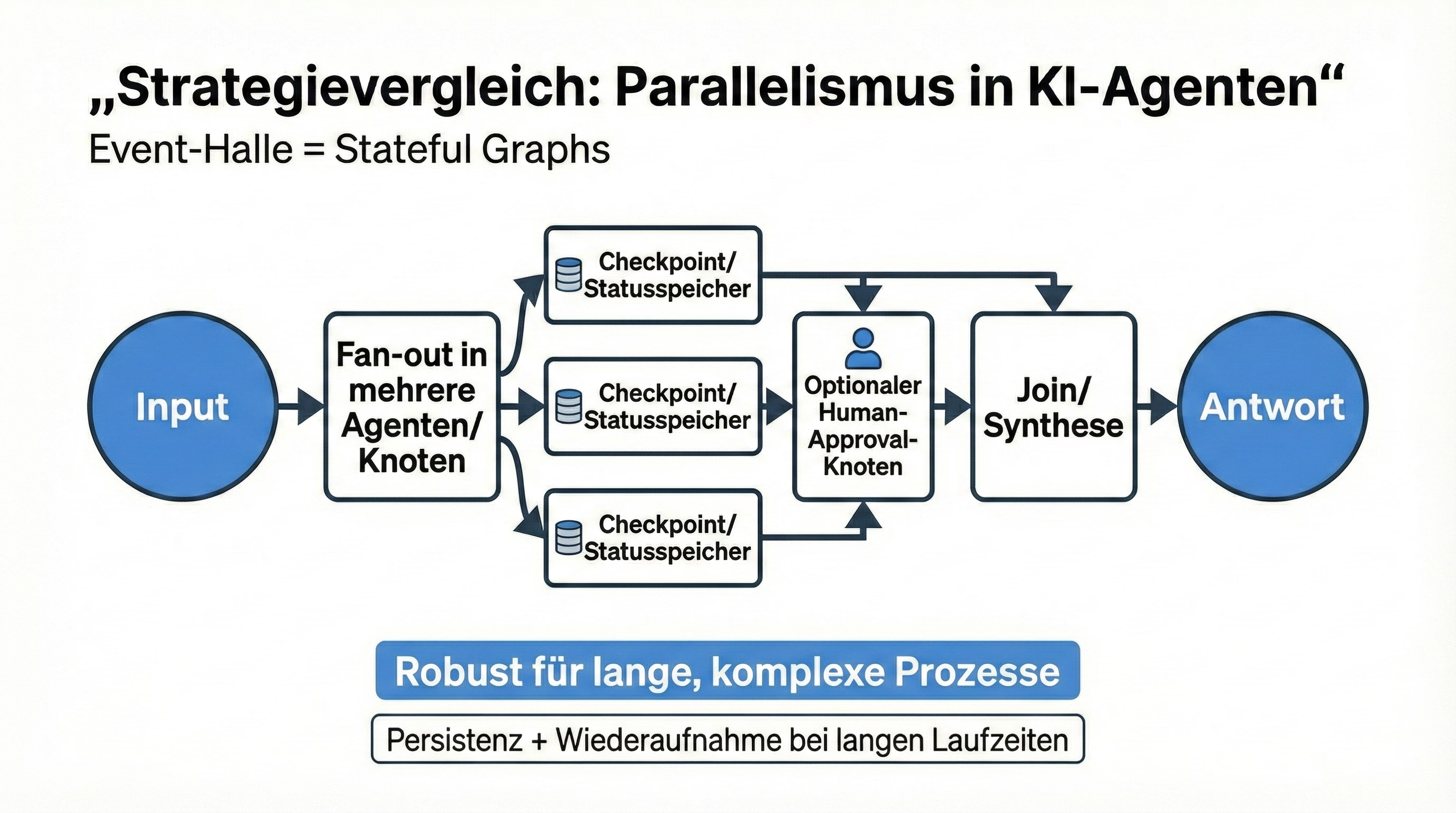

Die "Event-Halle" (Stateful Graphs)

Wenn du 500 Leute verpflegst, wird das Steak vielleicht um 14:00 Uhr angebraten, aber der Wein erst zum Toast um 18:00 Uhr eingeschenkt.

Hier glänzt eine Stateful Graph Architektur, typischerweise gebaut mit Frameworks wie LangGraph oder CrewAI. Hier nutzt der Agent ein "geteiltes Whiteboard" (ein persistentes State-Objekt), um parallele Aufgaben zu verfolgen, die Stunden dauern oder eine menschliche Freigabe in einem "Qualitätskontroll"-Knoten benötigen könnten.

Diese Systeme verwenden einen "Fan-out"-Ansatz, bei dem mehrere Agenten oder Knoten gleichzeitig ausgeführt werden, aber sie checkpointen auch ihren Fortschritt. Auf diese Weise wird, selbst wenn ein spezialisierter Sub-Agent (wie ein Deep-Research-Worker) zehn Minuten braucht, die Arbeit der restlichen Küche gespeichert, und das System "wacht" nur zur Synthese auf, wenn alle parallelen Zweige zurückgemeldet haben.

Wenn die Küche zur Fabrik wird: Das Map-Reduce-Muster

Während unser À-la-carte-Koch großartig für einen einzelnen Burger ist, was passiert, wenn ein ganzer Bus mit fünfzig hungrigen Touristen ankommt?

Du kannst nicht einfach "härter nachdenken", um das zu lösen; du brauchst ein System, um den riesigen Auftrag in mundgerechte Stücke zu zerteilen, alle gleichzeitig zu bearbeiten und dann wieder zusammenzufügen.

Dies ist das Map-Reduce-Muster. So handhaben moderne Agenten massive Datensätze, ohne an eine "Kontext-Wand" zu stoßen.

Stell dir vor, du übergibst einem Agenten einen 200-seitigen Rechtsvertrag und bittest um eine Zusammenfassung aller Risikofaktoren. Wenn der Agent versucht, alles auf einmal zu lesen, könnte er den Fokus verlieren oder das Kleingedruckte in der Mitte übersehen.

1. Die Map-Phase (Zerschneiden + Delegieren)

Der Agent "schneidet" den Vertrag in 10-seitige Kapitel und übergibt jedes einem anderen "Sous-Chef" (einem parallelen Arbeiter), um Risiken zu identifizieren. Jeder Sous-Chef arbeitet isoliert und konzentriert sich rein auf seine zugewiesenen Seiten.

2. Die Reduce-Phase (Deduplizieren + Synthetisieren)

Sobald die Sous-Chefs fertig sind, nimmt der Chefkoch diese separaten Risiko-Listen und reduziert sie, indem er Duplikate entfernt, ähnliche Probleme gruppiert und alles zu einem einzigen kohärenten Bericht verdichtet.

3. Das moderne Upgrade: Map-Reduce-Produce

Viele Teams erweitern dies zu Map-Reduce-Produce, wo die finale Ausgabe nicht nur eine Zusammenfassung ist, sondern ein handlungsfähiges Artefakt wie ein E-Mail-Entwurf an einen Anwalt, eine Reihe von Vertrags-Redlines oder ein ausgefülltes Risikobewertungs-Dashboard.

Dieses Muster ist der ultimative Latenz-Killer. Wenn es eine Minute dauert, zehn Seiten zu lesen, würde ein sequenzieller Agent zwanzig Minuten brauchen, um den Vertrag durchzugehen. Ein Map-Reduce-Agent kann alle Sous-Chefs gleichzeitig abfeuern und ein vergleichbares Ergebnis in etwa sechzig Sekunden liefern.

Es verwandelt den Agenten von einem cleveren Chatbot in eine industrietaugliche Intelligenz-Engine.

Kontrollierte vs. Emergente Parallelität: Das Dilemma des Architekten

Sobald du die Mechanik der Küche verstehst, stehst du vor einer tieferen architektonischen Wahl: Wie viel vom "Gehirn" sollte in deinem Code leben, und wie viel im Modell?

Wenn du dich für Kontrollierte Parallelität entscheidest, agierst du im Wesentlichen als Meister-Blaupausen-Designer. Du hast im Voraus entschieden, dass Task A und Task B gleichzeitig passieren müssen, weil du den Workflow in- und auswendig kennst. Es ist ein bisschen wie ein Fabrik-Fließband, bei dem jeder Roboter eine feste Station und eine bestimmte Zeit zum Zuschlagen hat.

Dieser Ansatz ist das Fundament vieler Unternehmens-Systeme, weil er nahezu totale Vorhersagbarkeit bietet und Ihr API-Budget fest im Griff hält. Der Kompromiss ist Starrheit: Wenn die Anfrage eines Nutzers außerhalb dieses vorgezeichneten Plans fällt, kann das System nicht improvisieren.

Emergente Parallelität geht den entgegengesetzten Weg, indem sie die KI eher wie einen Senior-Partner als einen Fabrikarbeiter behandelt. Du gibst dem Agenten ein Ziel und eine Suite von Tools (z.B. eine Suchmaschine, einen Taschenrechner und eine Datenbank), und das Reasoning-Engine des Modells entscheidet spontan, welche davon es zusammen auslösen soll.

Hier zeigt sich die Magie des "agentischen" Verhaltens wirklich und ermöglicht komplexe, offene Recherchen oder kreatives Problemlösen, das ein Mensch nie vollständig im Voraus abbilden könnte. Aber diese Freiheit kommt mit einer Volatilitäts-Steuer. Wenn ein Modell wie GPT-5 oder Claude 4 entscheidet, dass es fünfzehn Tools gleichzeitig aufrufen muss, um eine einfache Frage zu beantworten, werden deine Infrastruktur (und dein Geldbeutel) diesen Ansturm spüren.

Letztlich wählen die erfolgreichsten Agenten nicht das eine oder das andere, sondern sie nutzen einen Hybrid-Ansatz. Sie verwenden kontrollierte, statische Parallelisierung für den "Happy Path" (die 80% der Aufgaben, die häufig und vorhersagbar sind) und sparen die emergente, modellgeführte Kraft für die chaotischen Sonderfälle auf, die echtes "Denken" erfordern.

Indem du beide balancierst, baust du ein System, das so zuverlässig wie eine Fabrik, aber so anpassungsfähig wie ein menschlicher Mitarbeiter ist.

Die Kehrseite: Komplexität und Kosten

Parallelisierung ist kein "Gratis-Mittagessen". Während es Zeit spart, führt es neue Herausforderungen ein:

Komplexität: Das Debugging eines Systems, bei dem fünf Dinge gleichzeitig passieren, ist deutlich schwerer als das Debugging einer linearen Kette.

Kosten: Vier LLM-Aufrufe gleichzeitig auszuführen ist schneller, aber es kostet immer noch viermal so viel wie ein einzelner Aufruf.

Das Synchronisationsproblem: Dein finaler "Join"-Schritt kann nur so schnell sein wie die langsamste parallele Aufgabe. Wenn drei API-Aufrufe 1 Sekunde dauern, aber der vierte 5 Sekunden braucht, beträgt deine Gesamtwartezeit 5 Sekunden.

Das UX-Imperativ: In der modernen Ära erwarten Nutzer Streaming-Ergebnisse. Selbst in parallelen Workflows lässt das Anzeigen von "Worker 1 fertig... Worker 2 fertig..." während du auf die langsamste Aufgabe wartest die wahrgenommene Latenz viel niedriger erscheinen. Parallelisiere nicht nur dein Backend, parallelisiere auch dein Nutzer-Feedback.

Die operationellen Grenzen, vor denen niemand warnt

Jenseits der offensichtlichen Kosten- und Komplexitäts-Trade-offs gibt es subtilere Grenzen, die Teams in der Produktion beißen:

Merge-Konflikte im Join-Schritt: Wenn parallele Zweige unabhängig Ergebnisse zurückgeben, können sie sich widersprechen. Verschiedene Datenquellen können widersprüchliche Zahlen melden, oder zwei Arbeiter formatieren ihre Ausgabe auf inkompatible Weise. Der "Join"-Schritt ist nicht nur warten; es ist Konfliktlösung. Du brauchst explizite Regeln: Welche Quelle hat Vorrang? Wie deduplizierst du überlappende Erkenntnisse? Ein beliebter Ansatz ist die Verwendung eines LLM-as-a-Judge (LLM als Richter), um widersprüchliche Ausgaben zu bewerten und die beste Antwort auszuwählen oder zu synthetisieren. Ohne diese Konfliktlösungsstrategien produziert dein schön parallelisiertes System eine verwirrte, widersprüchliche finale Antwort.

Kontext-Fragmentierung: Wenn du eine große Aufgabe auf mehrere Arbeiter aufteilst, arbeitet jeder mit einem schmaleren Kontextausschnitt, den Entwickler als Lokalen Kontext bezeichnen würden. Ein Sous-Chef, der nur die Seiten 40–50 eines Vertrags liest, könnte eine Klausel auf Seite 12 verpassen, die die Bedeutung dessen, was er liest, vollständig ändert. Das ist, als würde man einen Sous-Chef bitten, ein Gericht vorzubereiten, ohne die Ernährungsbeschränkungen des Tisches zu kennen. Die Lösung besteht darin, den Lokalen Kontext jedes Arbeiters mit einem Globalen Kontext zu ergänzen (ein gemeinsames Briefing mit Schlüsseldefinitionen, Gesamtzielen und Ausgabe-Schemas), damit sie auch in Isolation ausgerichtet bleiben. Denk an Globalen Kontext als die Rezeptkarte der Küche, die an der Wand hängt: Jeder Koch kann das vollständige Menü und die Anrichteanleitungen sehen, auch wenn er nur für ein Gericht verantwortlich ist.

Fehlerbehandlung: Wenn parallele Aufgaben scheitern

In einer sequenziellen Kette stoppt der Prozess, wenn Schritt A fehlschlägt. Aber in einem parallelen Workflow, was passiert, wenn eine von vier Aufgaben fehlschlägt? Soll der gesamte Prozess abstürzen?

Denk zurück an die Restaurant-Analogie: Wenn der Sommelier den Schlüssel zum Weinkeller nicht finden kann, sollte die Küche das perfekt gekochte Steak und die Kartoffeln wegwerfen? Natürlich nicht.

In der Praxis behandeln gute parallele Systeme Fehlschläge nicht als binär. Sie behandeln sie als eine Menü-Entscheidung: Was können wir noch servieren, und wofür müssen wir uns entschuldigen?

Fallback-Logik und Teilergebnisse: Ein gut designtes paralleles System sollte elegant degradieren. Der Gast bekommt vielleicht nicht den Wein, aber er bekommt immer noch ein heißes Steak und Kartoffeln.

Hier ist das operative Playbook, das parallele Workflows davor bewahrt, ins Chaos zu stürzen:

Timeout-Budget (Aufhören zu warten): Entscheide, wie lange der Join-Schritt auf einen einzelnen Arbeiter warten wird. Wenn der Timer null erreicht, vereinige, was du hast, und liefere die bestmögliche Antwort.

Degradierter Modus (Serviere einen kleineren Teller): Wenn ein Zweig fehlschlägt, fahre mit Teilergebnissen fort und kennzeichne das fehlende Stück explizit. Nutzer verzeihen eine unvollständige Antwort; sie verzeihen kein Schweigen.

Das Ziel ist nicht "nie scheitern". Das Ziel ist, dass dein System wie eine professionelle Küche scheitert: Es hält den Service am Laufen und sagt dem Kunden, was passiert ist.

Fazit: Das Fünf-Sterne-Erlebnis servieren

Wir begannen mit einer Küche, die alles Schritt für Schritt erledigte: erst Kartoffeln, dann Steak, dann Wein. Das Problem war nicht der Aufwand, es war der Workflow. Wenn unabhängige Aufgaben in eine einzige Reihe gezwungen werden, zahlt der Kunde mit kaltem Essen und langen Wartezeiten.

Parallelisierung ist der Wandel von "mach den nächsten Schritt" zu "koordiniere die Arbeit". Indem du dich von starren, sequenziellen Ketten löst, sparst du nicht nur Millisekunden – du entwickelst dich von einem einfachen Chatbot zu einem System, das Aufgaben verzweigen, Ergebnisse vereinen, mit Map-Reduce skalieren und sicher pausieren kann, wenn ein Mensch den nächsten Schritt genehmigen muss.

Die Erwartungen der Nutzer haben sich verschoben. "Schnell" reicht nicht mehr; Nutzer erwarten, dass Agenten umfassend und kollaborativ sind. Sie wollen, dass das Steak, die Kartoffeln und der Wein jedes Mal im perfekten Moment eintreffen.

Wenn du diese Muster implementierst – die rohe Geschwindigkeit von GPT-5 mini mit dem tiefen Reasoning von Claude 4 balancierst und alles in einer persistenten, zustandsbehafteten Architektur verankerst – sparst du nicht nur Sekunden an Latenz. Du baust einen Agenten, der sich weniger wie ein langsames Computerprogramm und mehr wie ein Weltklasse-Team anfühlt.

Die "Ein-Sterne-Bewertung" ist ein Relikt der Vergangenheit. Es ist Zeit, das Fünf-Sterne-Erlebnis zu servieren.