Wenn du lange genug mit großen Sprachmodellen gearbeitet hast, kennst du diese Situation wahrscheinlich:

- Du schreibst einen sorgfältig ausgearbeiteten Prompt.

- Du erklärst die Aufgabe.

- Du fügst Einschränkungen, Sonderfälle und Beispiele hinzu.

Und trotzdem übersieht das Modell etwas Wichtiges.

Das liegt nicht daran, dass das Modell unfähig wäre. Es liegt daran, dass wir es oft bitten, zu viele Dinge gleichzeitig zu tun.

Trotz ihrer scheinbaren Intelligenz bearbeiten Sprachmodelle Aufgaben in der Regel in einem einzigen Durchlauf. Wenn ein Prompt Analyse, Schlussfolgerungen, Entscheidungen und Generierung gleichzeitig verlangt, muss das Modell mehrere Ziele parallel verfolgen – ohne explizite Struktur. Das Ergebnis sind fragile Argumentationen und inkonsistente Resultate.

Genau hier kommt Prompt Chaining ins Spiel.

Bevor wir erklären, was Prompt Chaining ist, hilft es zu verstehen, warum ein einzelner „besserer Prompt“ selten ausreicht.

Anstatt eine Aufgabe als eine einzige, monolithische Herausforderung zu betrachten, zerlegen wir sie in kleinere, handhabbare Teile. Jeder Teil hat ein klares Ziel, einen definierten Input und einen erwarteten Output. Das reduziert die kognitive Last, schärft die Intention und macht Fortschritt messbar.

Dasselbe Prinzip gilt für die Arbeit mit KI.

Einschränkungen – Warum nicht einfach einen besseren Prompt schreiben?

Eine häufige Reaktion auf fehlgeschlagene Prompts ist, noch mehr Details hinzuzufügen: längere Anweisungen, mehr Einschränkungen, mehr Beispiele. In der Praxis verschlechtert das das Ergebnis oft sogar.

Wenn wir zu viel von einem einzelnen Prompt verlangen, überfordern wir das Modell. Es soll die Aufgabe verstehen, konkurrierende Anforderungen abwägen, korrekt schlussfolgern und ein qualitativ hochwertiges Ergebnis liefern – alles in einem Schritt.

Mit zunehmender Komplexität treten mehrere typische Fehlermodi auf:

- Missachtung von Anweisungen: Teile des Prompts werden stillschweigend ignoriert

- Kontextdrift: Das Modell optimiert auf die letzten Tokens statt auf das ursprüngliche Ziel

- Fehlerverstärkung: Frühe Fehler werden nicht korrigiert, sondern fortgeschrieben

- Druck auf das Kontextfenster: Zu viele Informationen konkurrieren um begrenzte Aufmerksamkeit

- Halluzinationen: Hohe kognitive Last erhöht Fehlerraten und falsche Sicherheit

Diese Probleme entstehen nicht durch mangelnde Fähigkeiten, sondern durch fehlende Struktur. Wenn komplexe Aufgaben in einen einzigen Schritt gepresst werden, wird das Denken implizit, fragil und schwer kontrollierbar.

Ein Beispiel:

„Analysiere Nutzerfeedback, fasse die wichtigsten Erkenntnisse zusammen und entwickle eine Strategie zur Verbesserung des Produkts.“

Ein solcher Prompt kann eine brauchbare Zusammenfassung liefern, aber eine schwache Problembewertung oder falsche Verbesserungsvorschläge. Das Modell ist gezwungen, mehrere Ziele gleichzeitig zu verfolgen.

Denken in Rollen statt in Prompts

Anstatt einen großen Prompt zu schreiben, der Analyse, Bewertung, Entscheidung, Formatierung und Verifikation gleichzeitig verlangt, sollten wir einen Schritt zurücktreten und wie Forschende, Analyst:innen oder Architekt:innen denken.

Wie würde ein Mensch dieses Problem angehen?

In der realen Welt werden komplexe Probleme selten von einer einzelnen Person in einem einzigen Schritt gelöst. Unternehmen verteilen anspruchsvolle Aufgaben auf Spezialist:innen – jede Rolle mit klarer Verantwortung und Expertise.

Diese Logik lässt sich direkt auf die Arbeit mit KI übertragen.

Statt eines überladenen Prompts entwerfen wir mehrere Prompts, die jeweils eine spezifische „Rolle“ repräsentieren:

- ein Analyst, der das Problem versteht

- ein Stratege, der Lösungsansätze entwickelt

- ein Umsetzer, der das Ergebnis produziert

- ein Reviewer, der auf Fehler oder Inkonsistenzen prüft

Indem wir diese spezialisierten Prompts miteinander verketten und die Outputs jeweils als Input für den nächsten Schritt nutzen, entsteht eine Prompt-Kette, die menschliche Problemlösungsprozesse widerspiegelt.

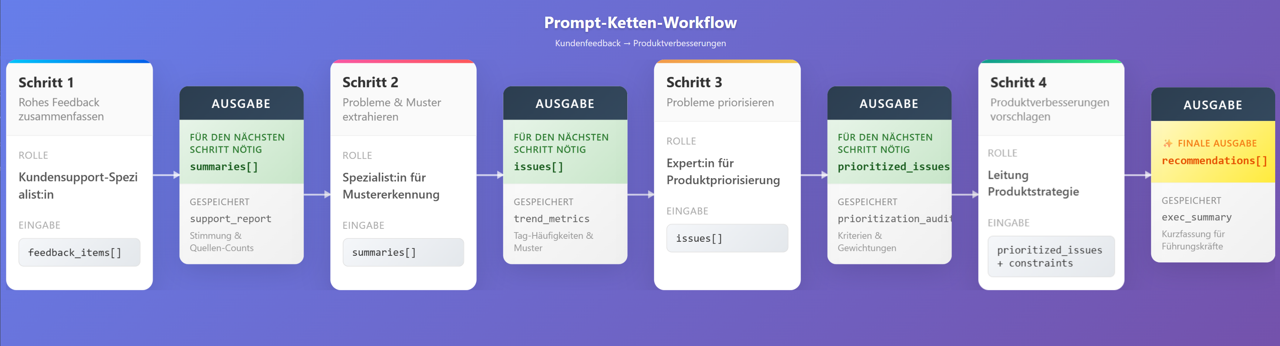

Beispiel: Von Kundenfeedback zu Produktverbesserungen

Die Umwandlung von rohem Kundenfeedback in konkrete Produktverbesserungen ist kein Ein-Schritt-Problem.

Ein typischer menschlicher Workflow sieht so aus:

- Lesen von Feedback aus verschiedenen Quellen (E-Mails, Reviews, Support-Tickets, Kommentare)

- Gruppieren ähnlicher Beschwerden und wiederkehrender Themen

- Priorisieren der Probleme nach Häufigkeit und Wirkung

- Ableiten konkreter Maßnahmen oder Verbesserungen

Jeder Schritt erfordert eine andere Denkweise:

Empathie beim Lesen, Mustererkennung beim Gruppieren, Urteilsvermögen bei der Priorisierung und strategisches Denken bei der Lösungsfindung.

Mit Prompt Chaining können wir diesen Prozess als Abfolge von Agenten modellieren:

Schritt 1: Aufgabe in spezialisierte Rollen und Teilprobleme zerlegen

- Customer-Support

Sammelt und fasst Feedback zusammen, mit Fokus auf Klarheit und Tonfall, nicht auf Schlussfolgerungen. - Pattern-Extraction

Identifiziert wiederkehrende Probleme, Themen und Trends. - Priority-Evaluation

Bewertet und priorisiert die extrahierten Probleme nach Häufigkeit, Schweregrad und Business-Impact. - Solution-Strategy

Entwickelt konkrete Produkt- oder Prozessverbesserungen für die wichtigsten Probleme.

Schritt 2: Strukturierte Inputs entwerfen

Nachdem eine komplexe Aufgabe in rollenspezifische Teilaufgaben zerlegt wurde, müssen wir verstehen, was jede Aufgabe tatsächlich benötigt.

Ein häufiger Fehler ist, sofort mit dem Schreiben von Prompts zu beginnen. Rollen allein reichen jedoch nicht aus. Eine Rolle ohne den richtigen Input ist nur ein Titel.

Jeder Schritt in einer Prompt-Kette sollte haben:

- eine klare Verantwortung

- einen klar definierten Input

- einen vorhersehbaren Output

Der Input bestimmt, worüber eine Aufgabe nachdenken kann – und genauso wichtig: was sie ignorieren soll.

Eine Analyse benötigt keine Formatierungsregeln. Eine Priorisierung benötigt keine rohen, ungefilterten Daten.

Hier geht es nicht um Prompt-Optimierung, sondern um das Design sauberer Schnittstellen zwischen Aufgaben.

Prompt-Ketten verhalten sich weniger wie Gespräche und mehr wie Softwaresysteme. Die Qualität des Gesamtsystems hängt nicht von cleveren Einzelprompts ab, sondern davon, wie präzise Informationen geformt und weitergegeben werden.

Die zentrale Frage für jeden Schritt lautet:

„Welche minimale Information benötigt diese Aufgabe, um ihre Arbeit gut zu erledigen – nicht mehr und nicht weniger?“

Schritt 3: Strukturierte Outputs entwerfen

Eine Prompt-Kette ist nur so zuverlässig wie die Daten, die durch sie fließen. Unklare oder lose strukturierte Outputs machen alle nachgelagerten Schritte fragiler.

Unstrukturierter Text lässt zu viel Interpretationsspielraum. Jeder nachfolgende Schritt muss Intention, Kontext und Relevanz neu interpretieren – was Drift, kognitive Last und Fehler begünstigt.

Strukturierte Outputs wirken hier wie explizite Verträge zwischen Aufgaben.

Beispiel für einen strukturierten Output eines Pattern-Extraction-Schritts:

{

"issues": [

{

"issue_name": "Langsame App-Performance",

"frequency": "hoch",

"summary": "Nutzer berichten über lange Ladezeiten und Verzögerungen."

},

{

"issue_name": "Unübersichtlicher Onboarding-Prozess",

"frequency": "mittel",

"summary": "Neue Nutzer verstehen zentrale Funktionen nicht."

}

]

}Solche Strukturen ermöglichen:

- eindeutige Interpretation

- deterministisches Parsing

- programmgesteuerte Validierung

- Isolierung einzelner Fehler

Takeaway:

Wenn Inputs definieren, worüber eine Aufgabe nachdenken kann, definieren Outputs, worauf sich das System verlassen kann.

Schritt 4: Prompts aus Rollen, Inputs und Outputs ableiten

Erst jetzt sind wir bereit, Prompts zu schreiben.

Prompts sind keine offenen Bitten mehr, sondern Implementierungen bereits getroffener Entscheidungen. Jeder Prompt ergibt sich direkt aus:

- der Rolle

- dem strukturierten Input

- dem erwarteten strukturierten Output

Dadurch werden Prompts kürzer, präziser und robuster. Sie lassen sich isoliert überprüfen, und Fehler bleiben lokal begrenzt.

Schritt 5: Prompts verketten und das System überprüfen

Beim Verketten geht es nicht nur um Reihenfolge, sondern um kontrollierten Informationsfluss.

Jeder Schritt sollte nur die Informationen erhalten, die er benötigt. Zusätzliche Metadaten oder Erklärungen sind Nebenprodukte – keine impliziten Inputs.

Die Prompt-Kette sollte als Gesamtsystem überprüft werden:

- Erhält jeder Schritt nur relevante Informationen?

- Sind Outputs konsistent strukturiert?

- Sind Verantwortlichkeiten sauber getrennt?

- Wo könnten Fehler weitergegeben werden?

Eine gute Prompt-Kette ist nicht statisch. Sie verbessert sich durch Tests, Beobachtung und gezielte Anpassungen.

Wann Prompt Chaining übertrieben ist

Prompt Chaining ist mächtig – aber nicht immer sinnvoll.

Oft ist es Overkill bei:

- Einfachen Transformationen (Umschreiben, Übersetzen, Formatieren)

- Kreativen, offenen Aufgaben wie Brainstorming oder freiem Schreiben

Prompt Chaining entfaltet seinen Wert dort, wo Struktur, Zuverlässigkeit und Nachvollziehbarkeit entscheidend sind. Wo sie es nicht sind, ist Einfachheit meist die bessere Wahl.